استعد بسرعة، وداعًا للتعقيد

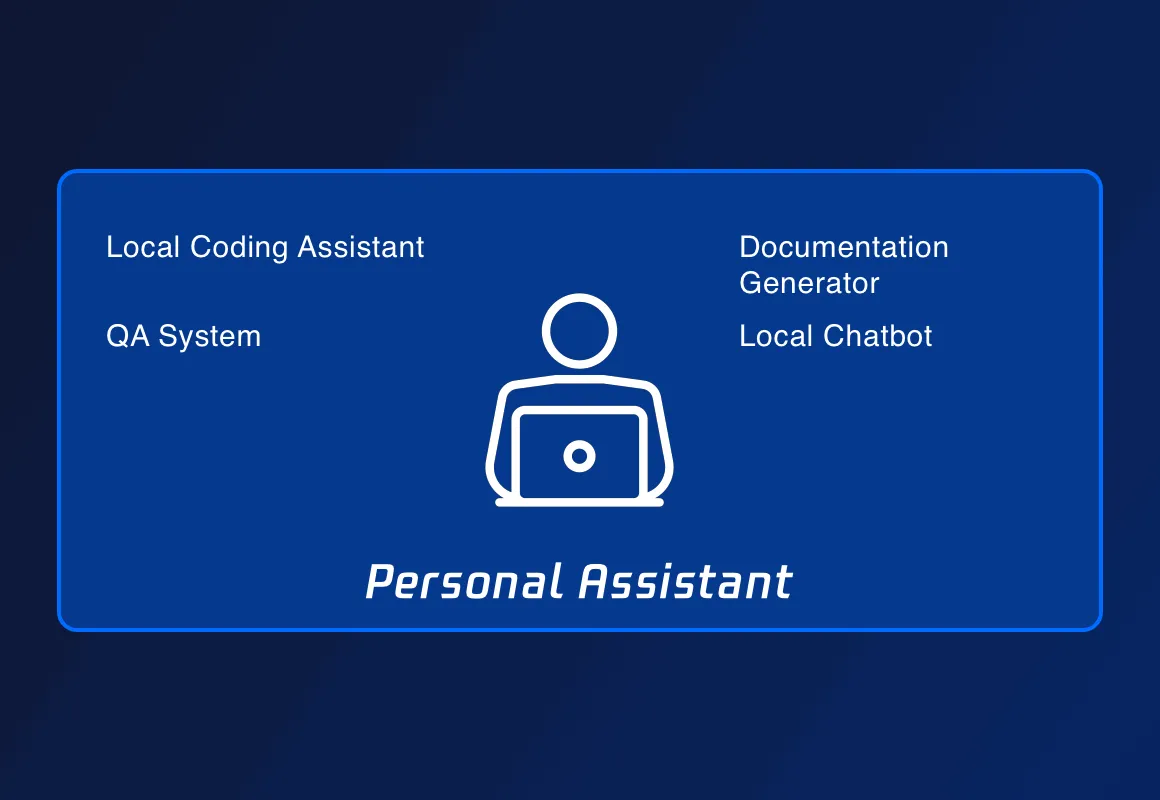

تكمن المزايا الرئيسية لـ ServBay في تثبيت LLM بنقرة واحدة، التشغيل المحلي، حماية خصوصية البيانات، إمكانية الاستخدام بدون اتصال، وانخفاض التكلفة. مقارنةً بخدمات LLM السحابية، لا تحتاج ServBay إلى اتصال بالإنترنت، وتبقى البيانات محلية، مما يعني عدم القلق بشأن تسرب الخصوصية.

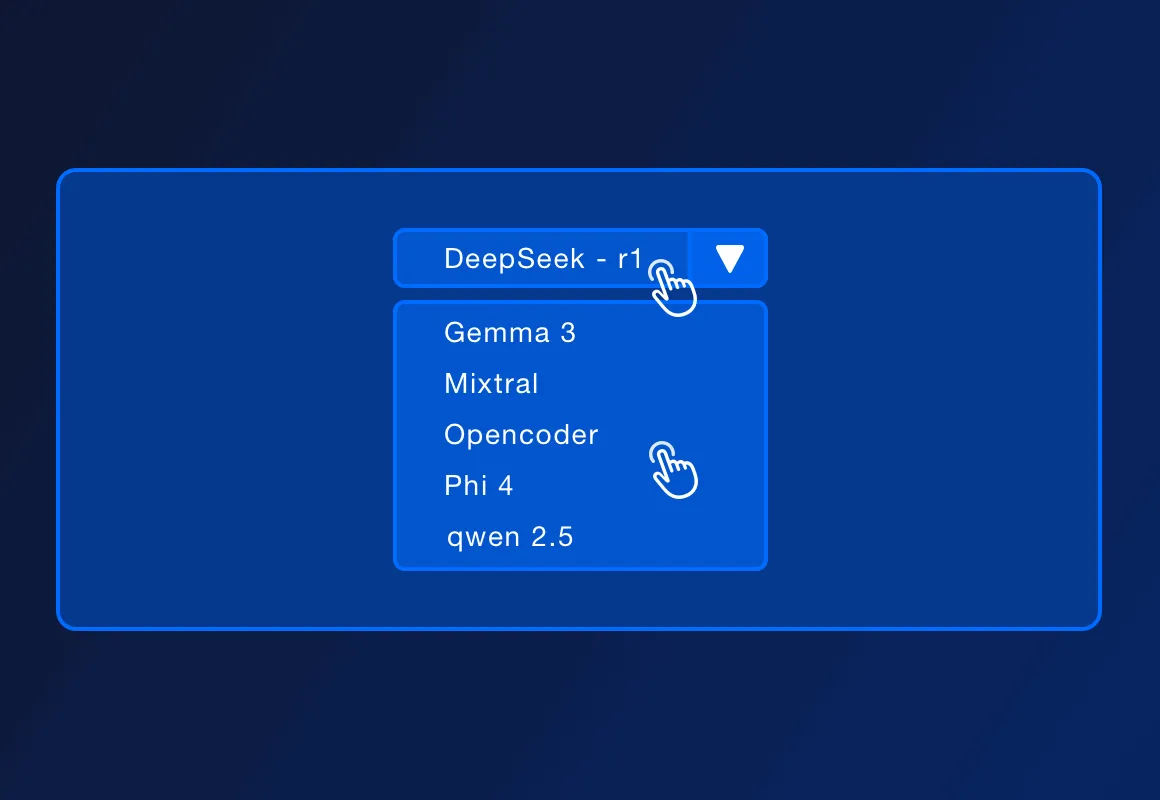

تدعم ServBay مجموعة من نماذج LLM المفتوحة المصدر الشهيرة مثل DeepSeek - r1، Llama 3.3، Mistral، Code Llama، وغيرها. قد تتزايد قائمة النماذج المدعومة مع التحديثات الرسمية.

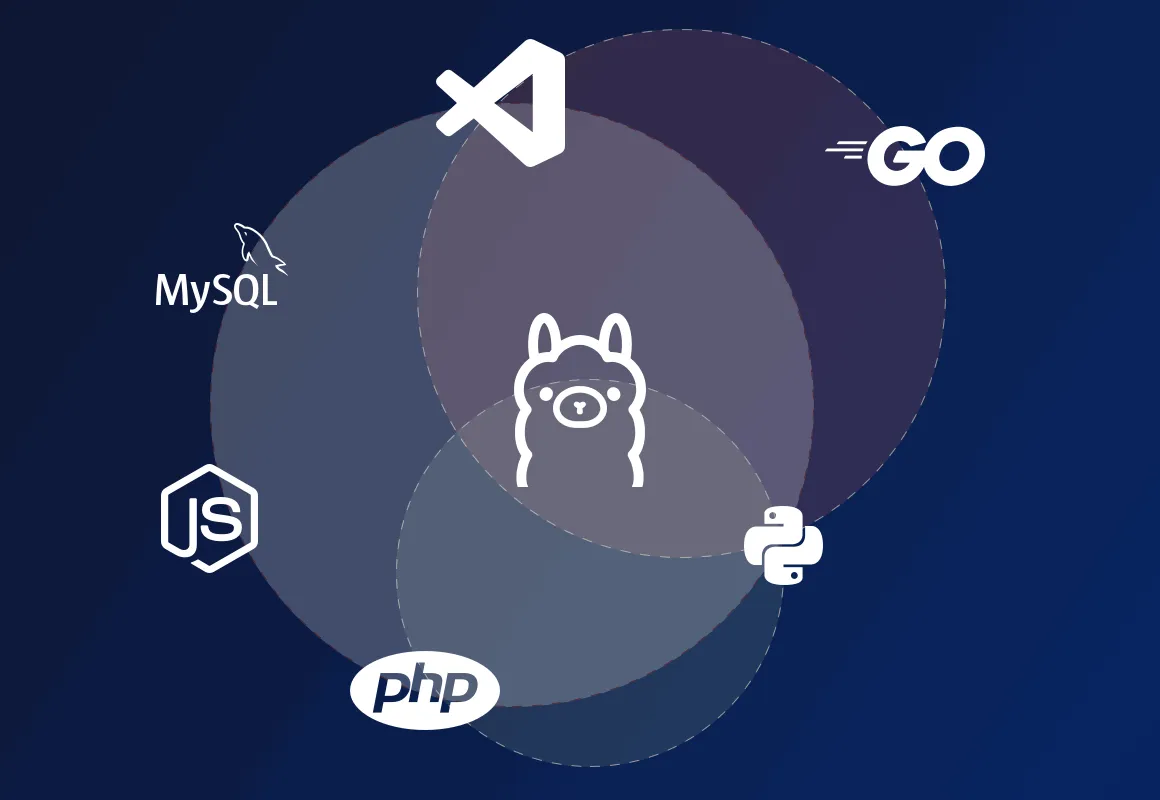

تدعم ServBay نشر بيئات تطوير محلية باستخدام PHP، Python، Node.js، Go، مما يجعلها مناسبة للتطوير المحلي، وتصميم النماذج، وعمليات التعلم، والاستخدام الشخصي. في بيئات الإنتاج التي تتطلب توافد عالي، توفر ServBay أيضًا حلول نشر أكثر احترافية.

تعد ServBay منصة إدارة بيئات التطوير، توفر نشر بيئات تطوير للغات مثل PHP، Python، Node.js، Go، بالإضافة إلى دعم مختلف قواعد البيانات والخوادم. الآن، تدعم ServBay أيضًا تثبيت Ollama بنقرة واحدة، حيث يمكن للمطورين التفاعل مع النماذج التي تعمل محليًا من خلال واجهة REST API المقدمة بواسطة Ollama، وإرسال مدخلات نصية واستقبال مخرجات النموذج، مما يمكنهم من بناء تطبيقات وخدمات مدفوعة بالذكاء الاصطناعي محليًا.