Rascher Einstieg, Verabschiedung von Komplexität

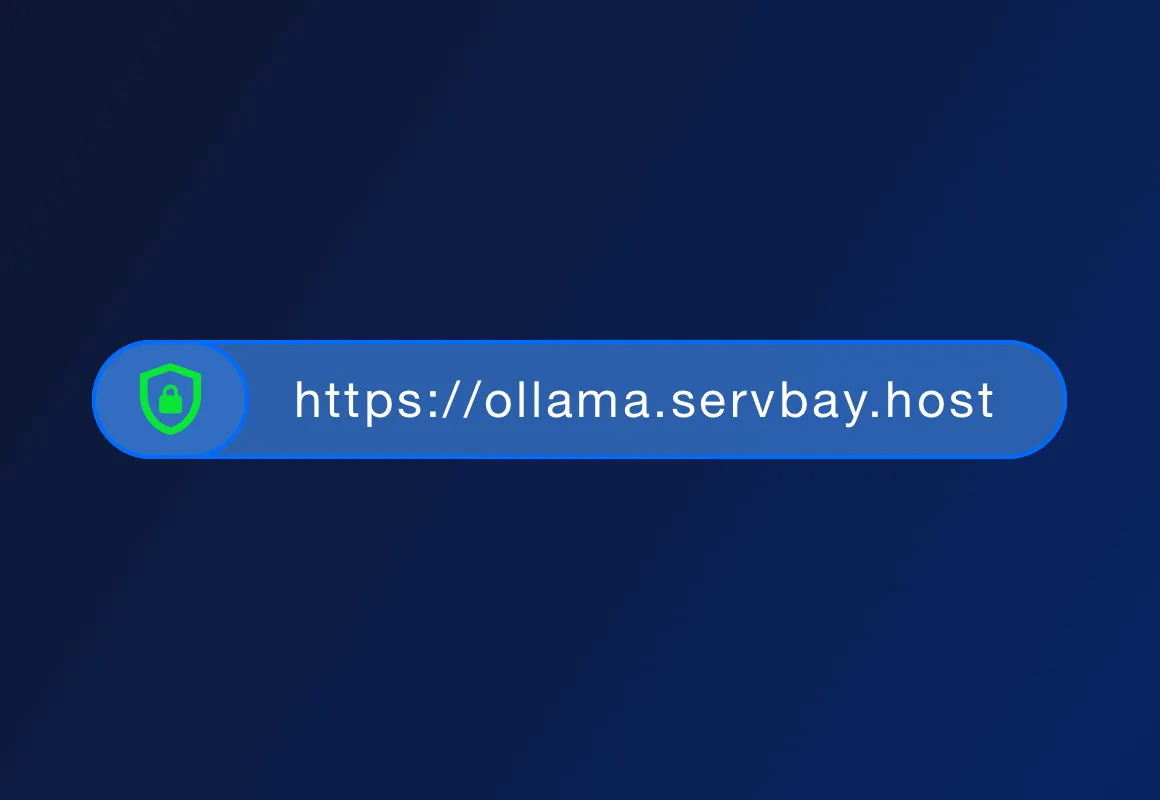

Die Hauptvorteile von ServBay liegen in der Ein-Klick-Installation von LLMs, lokalem Betrieb, Datenschutz, Offline-Nutzung und niedrigeren Kosten. Im Gegensatz zu Cloud-LLM-Diensten benötigt ServBay keine Netzwerkverbindung, die Daten verbleiben lokal, und es gibt keine Bedenken bezüglich Datenschutzverletzungen.

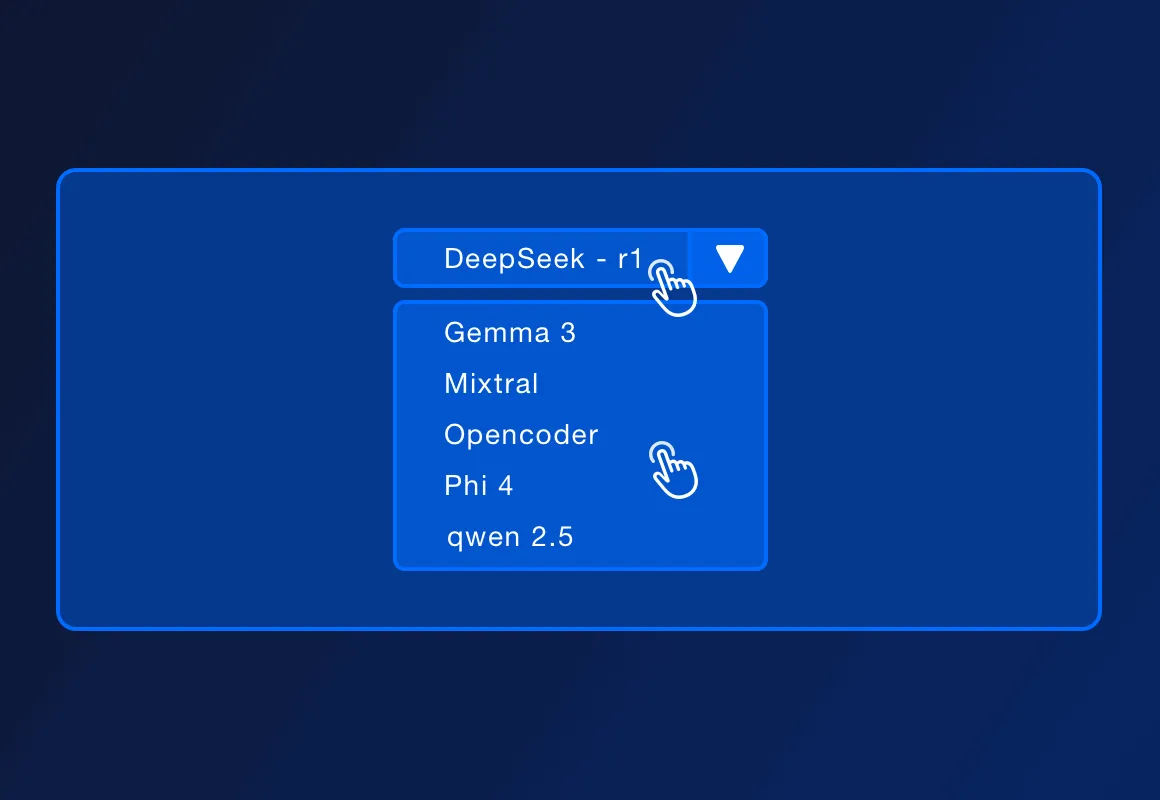

ServBay unterstützt mehrere beliebte Open-Source-LLMs, wie DeepSeek - r1, Llama 3.3, Mistral, Code Llama usw. Die Liste der unterstützten Modelle kann mit offiziellen Updates erweitert werden.

ServBay unterstützt die Bereitstellung von lokalen Entwicklungsumgebungen für PHP, Python, Node.js, Go usw. und ist zusammen mit Ollama für lokale Entwicklung, Prototypen-Design, Lernen und die persönliche Nutzung geeignet. In Produktionsumgebungen, die hohe Parallelität, hohe Verfügbarkeit und komplexe Verwaltungsfunktionen erfordern, kann ServBay auch professionellere Bereitstellungslösungen bieten.

ServBay selbst ist eine Plattform zur Verwaltung von Entwicklungsumgebungen, die bereitgestellt wird für die Entwicklung in PHP, Python, Node.js und Go, und bietet zudem Unterstützung für verschiedene Datenbanken und Server. Jetzt unterstützt ServBay auch die One-Click-Installation von Ollama, sodass Entwickler über die von Ollama bereitgestellte REST-API mit lokal ausgeführten Modellen interagieren, Texteingaben senden und Modellausgaben empfangen können, um so verschiedene KI-gesteuerte Anwendungen und Dienste lokal aufzubauen.