Comienza rápidamente, despídete de la complejidad

Las principales ventajas de ServBay residen en la instalación de LLM con un clic, ejecución local, privacidad de datos, disponibilidad fuera de línea y costos relativamente bajos. A diferencia de los servicios LLM en la nube, ServBay no requiere conexión a Internet, y los datos se mantienen localmente, sin preocupaciones por la filtración de privacidad.

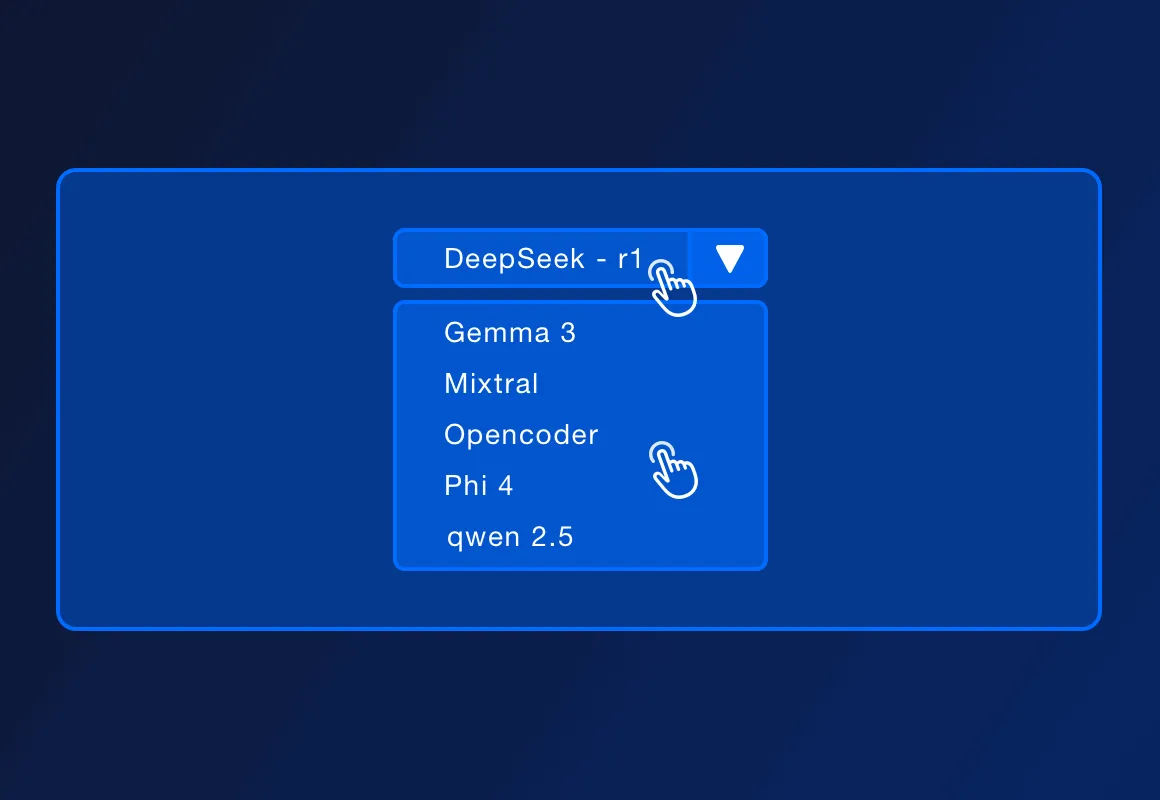

ServBay es compatible con varios LLM de código abierto populares, como DeepSeek - r1, Llama 3.3, Mistral, Code Llama, entre otros. La lista específica de modelos compatibles puede aumentar con las actualizaciones oficiales.

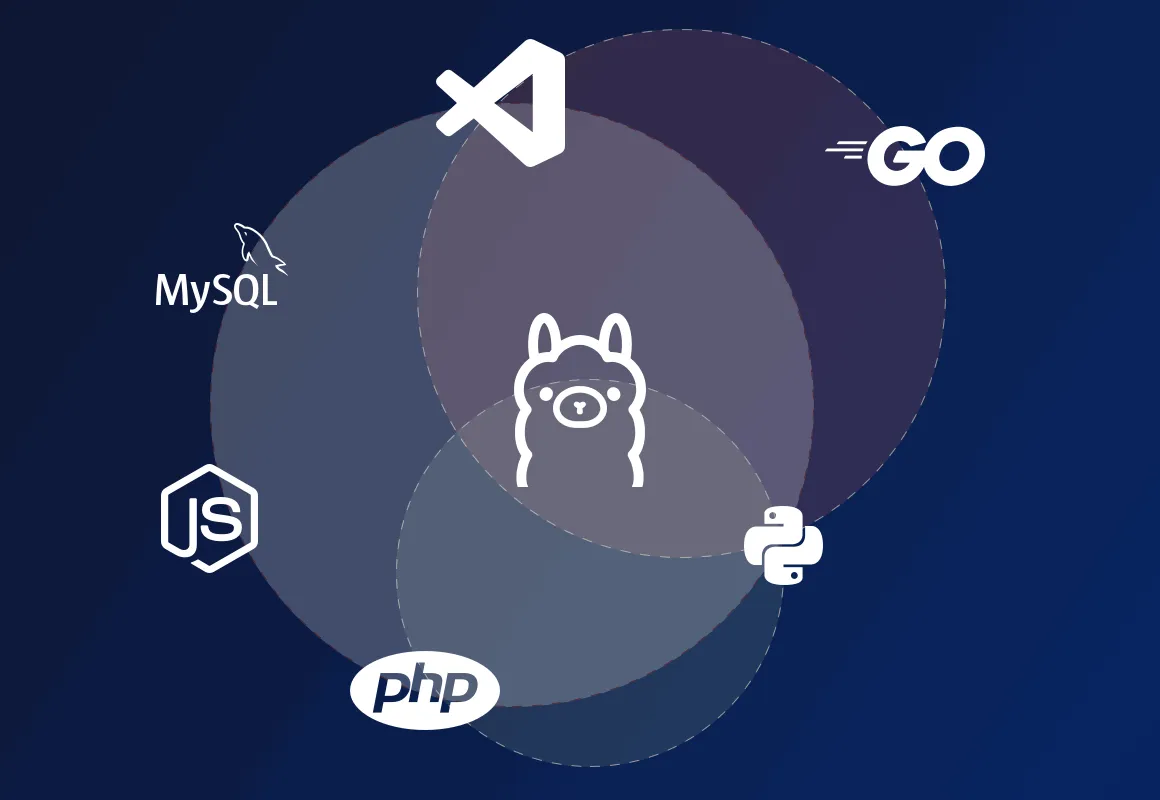

ServBay soporta despliegues de entornos de desarrollo locales en PHP, Python, Node.js, Go, etc. Junto con Ollama, es adecuado para desarrollo local, diseño de prototipos, aprendizaje y uso personal. En entornos de producción que requieren alto rendimiento concurrente, alta disponibilidad y funciones de gestión complejas, ServBay también puede ofrecer soluciones de despliegue más profesionales.

ServBay es en sí misma una plataforma de gestión de entornos de desarrollo, ofreciendo despliegue de entornos de desarrollo para lenguajes como PHP, Python, Node.js y Go, así como soporte para diversas bases de datos y servidores. Ahora ServBay soporta además la instalación de Ollama con un clic, permitiendo a los desarrolladores interactuar con los modelos que se ejecutan localmente a través de la API REST que proporciona Ollama, enviando entradas de texto y recibiendo salidas del modelo, lo que permite construir diversas aplicaciones y servicios impulsados por IA localmente.