Immediato, addio alla complessità

I principali vantaggi di ServBay includono l’installazione con un clic di LLM, l’esecuzione locale, la privacy dei dati, l’uso offline e costi inferiori. Rispetto ai servizi LLM in cloud, ServBay non richiede una connessione di rete, i dati rimangono locali e non c’è rischio di violazione della privacy.

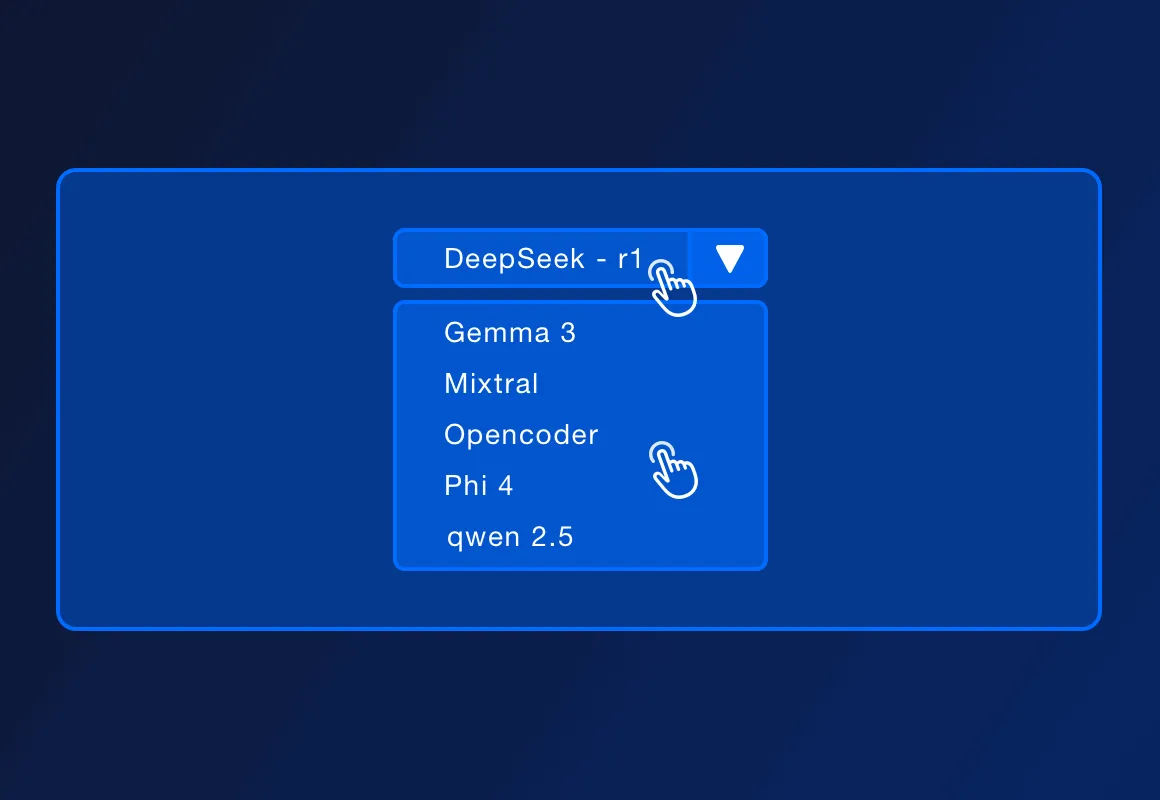

ServBay supporta diversi LLM open source popolari, come DeepSeek - r1, Llama 3.3, Mistral, Code Llama e altri. L'elenco specifico dei modelli supportati potrebbe aumentare con gli aggiornamenti ufficiali.

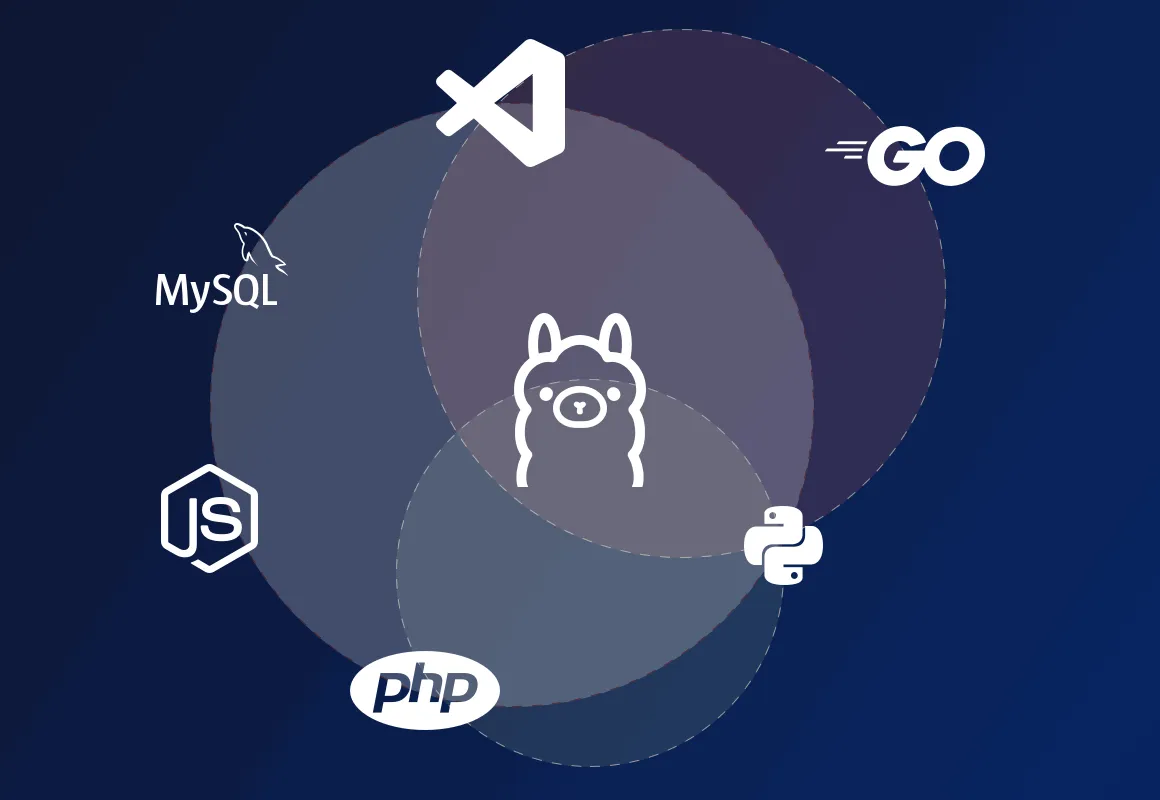

ServBay supporta la distribuzione di ambienti di sviluppo locali in PHP, Python, Node.js e Go, ed è adatto per sviluppo locale, progettazione di prototipi, apprendimento e uso personale. ServBay può anche fornire soluzioni di distribuzione più professionali in ambienti di produzione dove è necessaria elevata concorrenza, alta disponibilità e funzionalità di gestione complesse.

ServBay è una piattaforma di gestione dell’ambiente di sviluppo stesso, fornendo distribuzione di ambienti di sviluppo in linguaggi come PHP, Python, Node.js e Go, oltre a supportare vari database e server. Ora ServBay supporta anche l’installazione con un clic di Ollama, gli sviluppatori possono interagire con i modelli eseguiti localmente tramite le API REST fornite da Ollama, inviando input testuali e ricevendo output dai modelli, consentendo così di costruire varie applicazioni e servizi basati su AI in locale.