素早く始められ、複雑さから解放

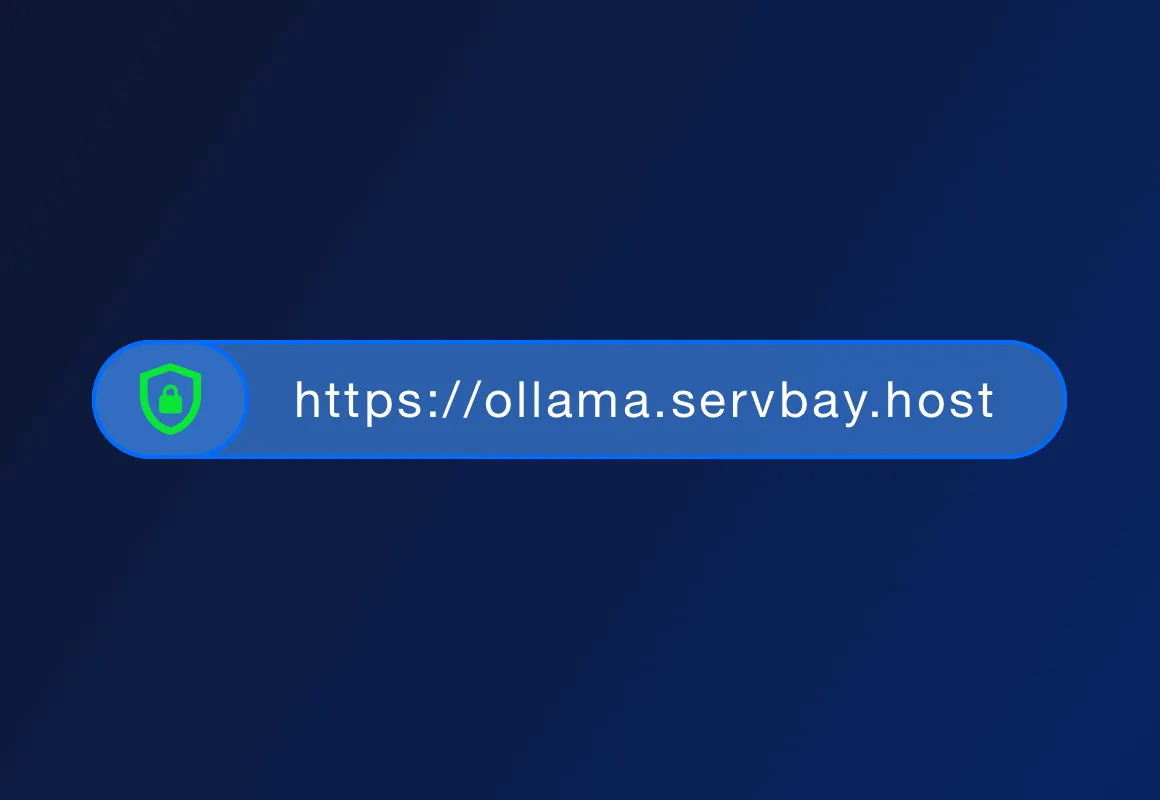

ServBayの主な利点は、ワンクリックでのLLMインストール、ローカル実行、データプライバシー、オフライン利用、低コストです。クラウドLLMサービスとは異なり、ServBayはネットワーク接続を必要とせず、データはローカルに保持され、プライバシー漏洩を心配する必要がありません。

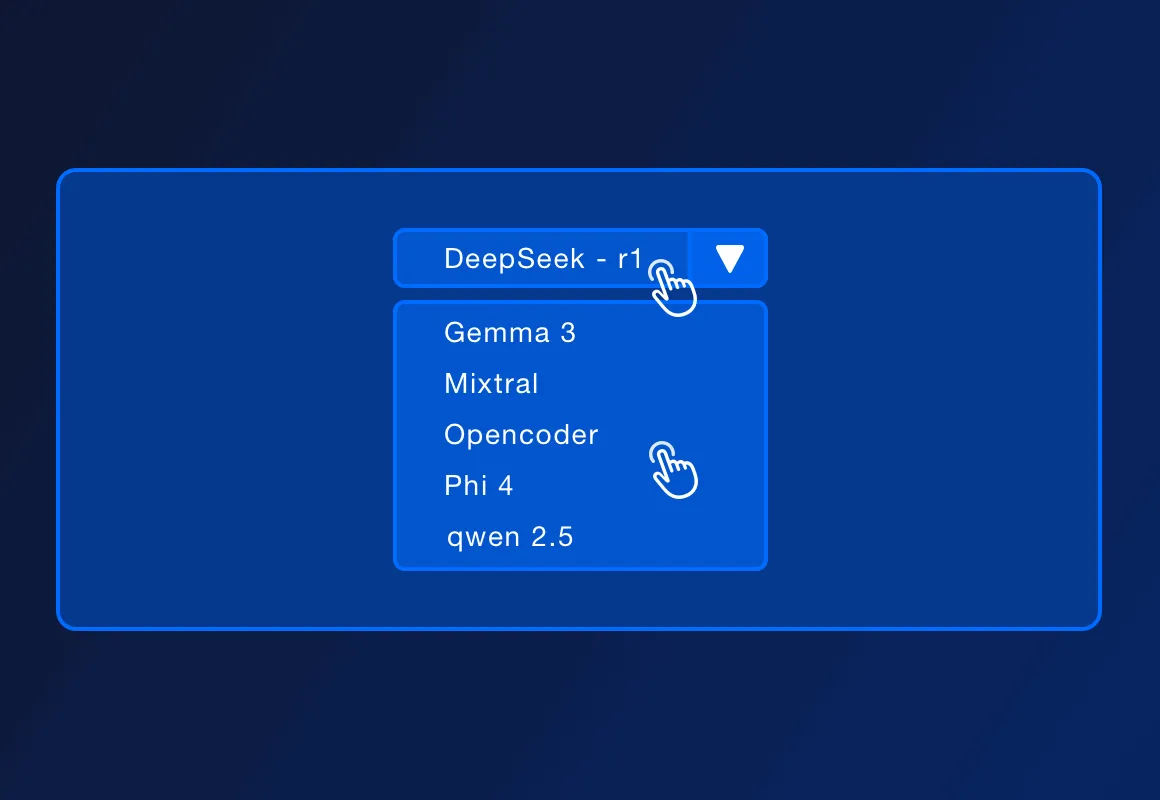

ServBayは、DeepSeek - r1、Llama 3.3、Mistral、Code Llamaなど、さまざまな人気のあるオープンソースLLMをサポートしています。具体的なモデルのリストは、公式の更新に応じて増加する可能性があります。

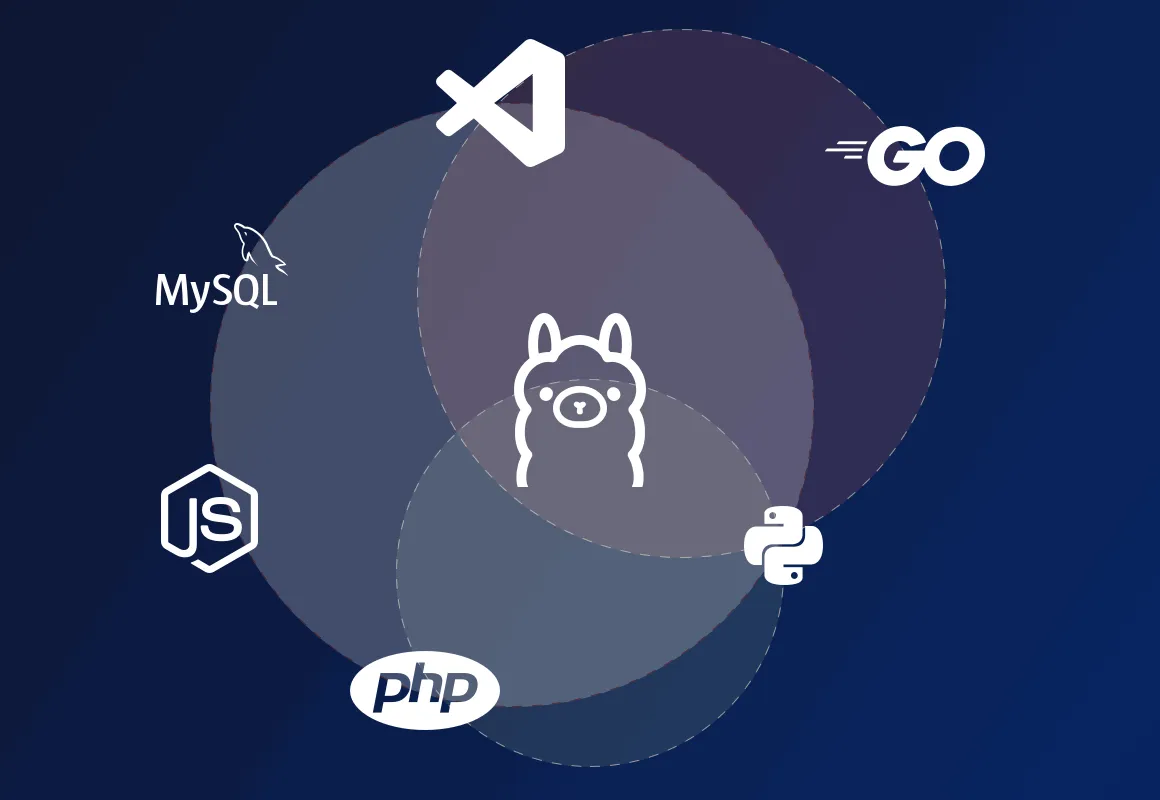

ServBayは、PHP、Python、Node.js、Goなどのローカル開発環境の展開をサポートし、Ollamaと組み合わせることで、ローカル開発、プロトタイプ設計、学習、個人使用に適しています。高い同時アクセス、高可用性、および複雑な管理機能が必要な生産環境においても、ServBayはより専門的な展開ソリューションを提供できます。

ServBay自体が開発環境管理プラットフォームであり、PHP、Python、Node.js、Goなどの開発環境を提供し、さまざまなデータベースやサーバーのサポートを提供します。現在、ServBayではOllamaのワンクリックインストールもサポートしており、開発者はOllamaが提供するREST APIを通じてローカル実行中のモデルと相互作用し、テキスト入力を送り、モデル出力を受信することで、ローカルでさまざまなAI駆動のアプリケーションやサービスを構築できます。