Мгновенное начало, прощай сложность

Основные преимущества ServBay заключаются в однократной установке LLM, локальном функционировании, конфиденциальности данных, доступности в оффлайн-режиме, низкой стоимости. В отличие от облачных LLM сервисов, ServBay не требует сетевого соединения, данные остаются локально, не беспокоясь о утечке конфиденциальной информации.

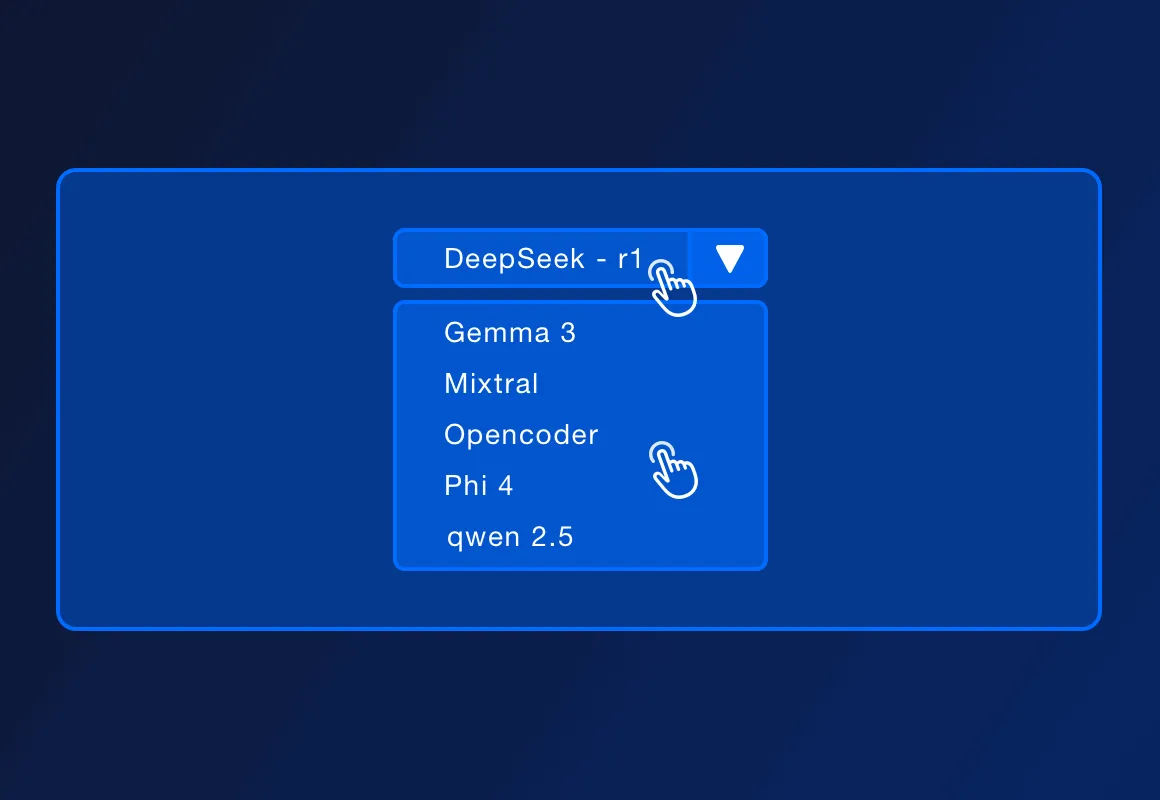

ServBay поддерживает несколько популярных открытых LLM, таких как DeepSeek - r1, Llama 3.3, Mistral, Code Llama и т.д. Список поддерживаемых моделей может увеличиваться с обновлениями от официальных источников.

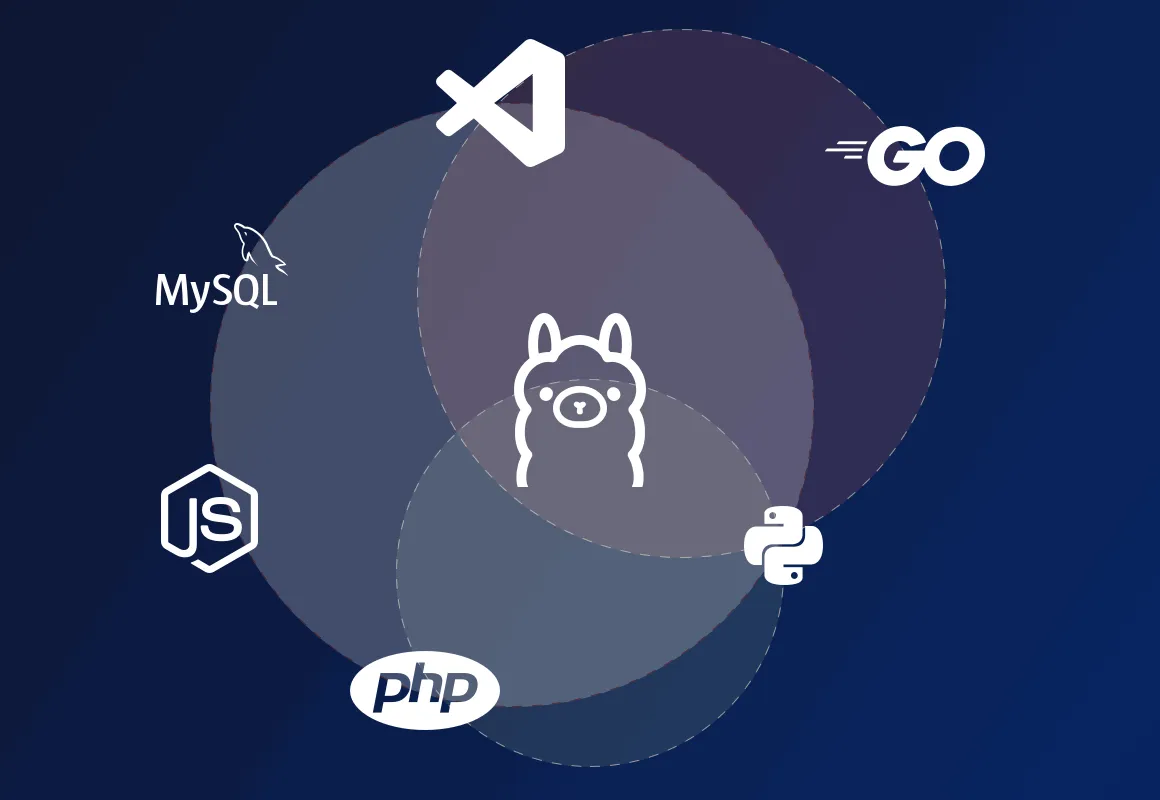

ServBay поддерживает развёртывание локальных сред разработки на PHP, Python, Node.js, Go и сочетается с Ollama, подходит для локальной разработки, проектирования прототипов, обучения и личного использования. В производственной среде, требующей высокой пропускной способности, высокой доступности и сложного управления, ServBay также может предложить более профессиональные решения для развертывания.

ServBay сам по себе является платформой управления средой разработки, предоставляя развертывание сред разработки на таких языках, как PHP, Python, Node.js и Go, а также предлагая поддержку различных баз данных и серверов. Теперь ServBay дополнительно поддерживает однократную установку Ollama; разработчики могут взаимодействовать с локально работающими моделями через REST API, отправляя текстовые входные данные и получая вывод модели, позволяя созданию различных AI-управляемых приложений и сервисов локально.