极速上手,告别复杂

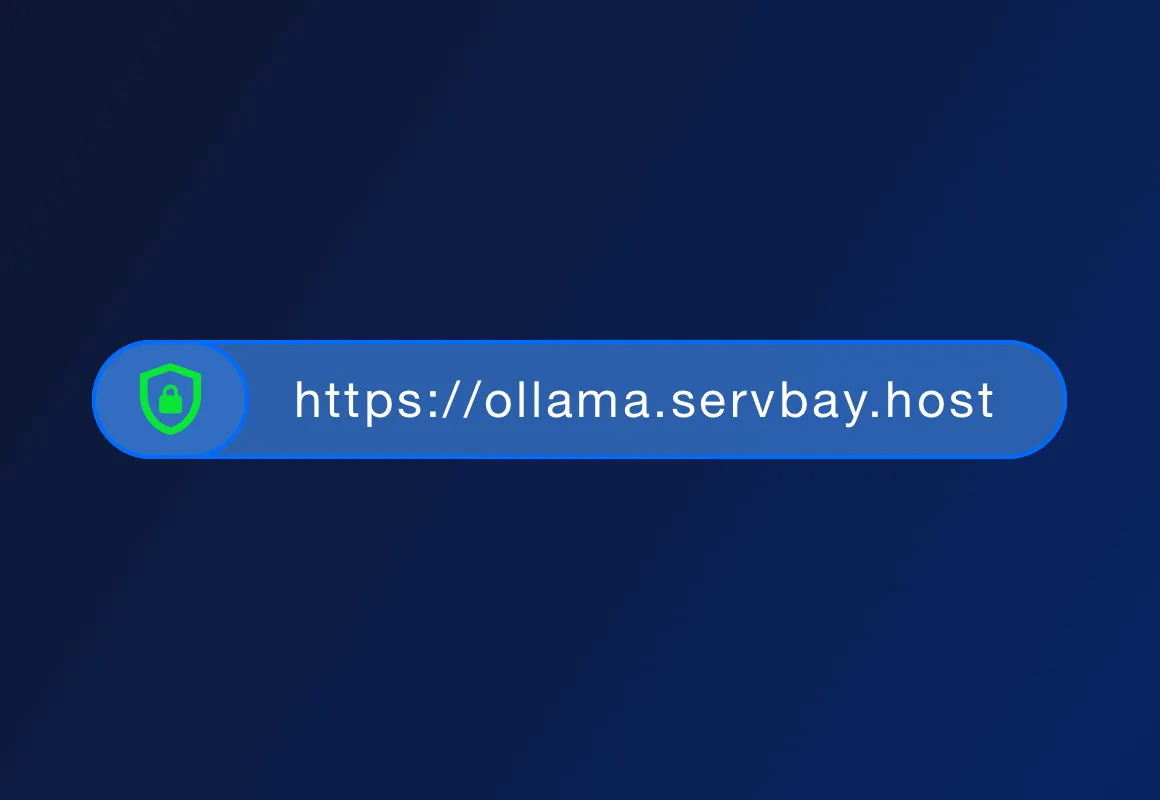

ServBay 的主要优势在于一键安装LLM、本地运行、数据隐私、离线可用、成本较低。与云端 LLM 服务相比,ServBay 不需要网络连接,数据保留在本地,不用担心隐私泄露。

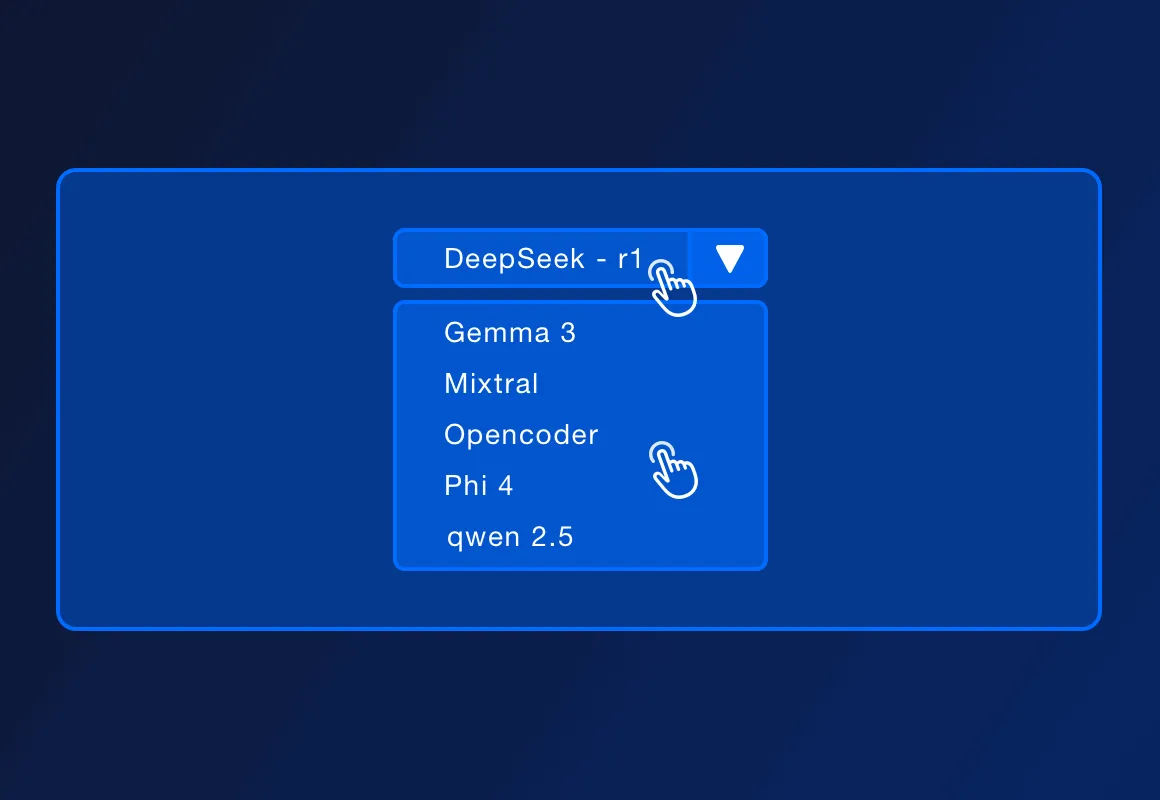

ServBay 支持多种流行的开源 LLM,例如 DeepSeek - r1、Llama 3.3、Mistral、Code Llama 等。具体支持的模型列表可能会随着官方的更新而增加。

ServBay 支持PHP、Python、Node.js、Go等本地开发环境部署,结合Ollama一起,适合本地开发、原型设计、学习和个人使用。在需要高并发、高可用性和复杂管理功能的生产环境中,ServBay也能提供更专业的部署方案。

ServBay自身就是开发环境管理平台,提供PHP、Python、Node.js和Go等语言的开发环境部署,并且还提供各种数据库和服务器支持。现在ServBay更是支持一键安装Ollama,开发者可以通过 Ollama 提供的 REST API 与本地运行的模型进行交互,发送文本输入并接收模型输出,由此可以在本地构建各种 AI 驱动的应用和服务。